哎呦,这个问题可太常见了!读取变量环境batch失败,说白了就是程序找不到它需要的环境变量。这玩意儿就好比你让外卖小哥送货,结果地址写错了,那肯定送不到啊!

在bash_profile里添加环境变量的时候,一定要用冒号分割路径,然后记得用source .bash_profile让它生效。Batch(cmd.exe)中读取环境变量也是同样的道理,Java启动程序需要正确配置才能找到依赖。要是环境变量没配好,程序运行起来就会一脸懵逼,直接给你报错!

循环索引变量无效问题

哇塞,这个错误信息看着就头疼!"循环索引变量'BATCH_'的使用无效"其实就是告诉你,程序里用了没声明的变量。就好比你突然喊一个陌生人的名字,人家肯定不知道你在叫谁嘛。解决办法就是检查代码,在使用BATCH_变量之前一定要先声明它,特别是在游标循环里使用的时候。

Tensorflow GPU配置问题

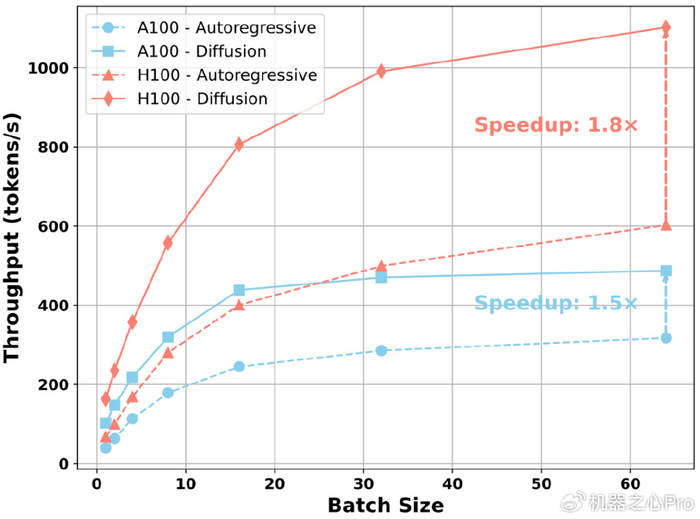

配置GPU环境真是个技术活!环境变量配置不对的话,PyCharm就找不到CUDA安装目录,训练时还会出现OOM错误。OOM说白了就是GPU内存不够用,这时候可以尝试减小batch size,或者换个内存更大的GPU。要是本地设备配置不够,也可以考虑用云端服务器来跑训练。

yock批处理脚本使用

yock这个工具还挺好用的,它提供了工作区导航、环境变量管理这些功能。比如cd命令切换目录,export设置环境变量,还能用sudo获取管理员权限。用yock替代batch和shell脚本,能让你少踩不少坑!

Colabfold微调报错

遇到batch.py报错的时候,别慌!这通常是因为Python解释器找不到模块路径。可以检查sys.path设置,或者设置PYTHONPATH环境变量。调试的时候多加点日志输出,这样就能更快定位问题所在。

torch训练自动退出

训练过程中突然退出,exitcode=-9,这八成是内存不足导致的。GPU内存不够的话,系统会自动终止进程。可以通过nvidia-smi查看显存占用情况,如果接近上限就要减小batch_size,或者启用混合精度训练来节省内存。

starrocks数据加载问题

"failed to send batch"错误一般是数据写入超时导致的。可以尝试增大query_timeout值,或者修改BE配置参数。HDFS集成时要确保集群配置正确,特别是HA模式下的各种参数设置。

哎呀,这个问题问得好!环境变量配置后不生效,最常见的原因就是没有重新加载配置。就好比你换了手机号,但忘记告诉朋友们,他们当然还是打你旧号码啦!配置完环境变量后,一定要执行source命令或者重新启动终端,让系统重新读取配置文件。另外还要检查一下配置的路径是否正确,有时候手抖多打了个空格或者少写了个字母,都会导致配置失效。如果还是不行,可以试试echo $变量名来检查变量是否真的设置成功了。

排查程序报错其实有个小窍门!首先别慌,仔细阅读错误信息,通常错误提示都会告诉你问题出在哪里。然后可以按照"从简单到复杂"的顺序排查:先检查环境变量、配置文件这些基础设置,再看代码逻辑有没有问题。如果是训练过程中报错,可以尝试减小数据规模或者降低复杂度来测试。还有个超级实用的技巧就是加日志,在关键步骤输出一些调试信息,这样就能像侦探破案一样,一步步追踪到问题的根源!

遇到GPU内存不足的情况,可以试试这几个方法:首先是减小batch_size,这是最直接有效的办法;其次可以使用梯度累积技术,模拟更大的batch_size;还可以启用混合精度训练,减少内存占用。如果这些方法都不行,那就只能考虑升级硬件了,或者把任务放到云端GPU服务器上运行。记住哦,在开始训练前最好先用nvidia-smi命令查看一下显存使用情况,做到心中有数!

管理批处理脚本的环境变量可得小心点!首先要确保变量名的唯一性,不要和系统变量冲突;其次要注意变量的作用域,有些变量只在当前会话有效,重启后就失效了。在使用export设置变量时,记得检查路径分隔符是否正确,Linux用冒号,Windows用分号。还有个重要提示:敏感信息不要直接写在脚本里,最好通过配置文件或者密钥管理工具来管理。这样才能既安全又方便地使用环境变量!

添加评论